Μια τεχνική επίθεσης που ανακαλύφθηκε πρόσφατα αποκάλυψε μια κρίσιμη αδυναμία στους βοηθούς κώδικα τεχνητής νοημοσύνης, οπλίζοντας τα ενσωματωμένα χαρακτηριστικά ασφαλείας τους.

Η επίθεση, γνωστή ως Lies-in-the-Loop, χειρίζεται την εμπιστοσύνη των χρηστών στα παράθυρα διαλόγου έγκρισης που έχουν σχεδιαστεί για να αποτρέπουν την εκτέλεση επιβλαβών λειτουργιών χωρίς ρητή άδεια.

Η ευπάθεια στοχεύει τα στοιχεία ελέγχου Human-in-the-Loop, τα οποία λειτουργούν ως τελική προστασία πριν από την εκτέλεση ευαίσθητων λειτουργιών.

Αυτά τα παράθυρα διαλόγου ζητούν από τους χρήστες να επιβεβαιώσουν ενέργειες πριν το σύστημα εκτελέσει δυνητικά επικίνδυνες εντολές. Ωστόσο, οι εισβολείς βρήκαν έναν τρόπο να εξαπατήσουν τους χρήστες πλαστογραφώντας ό,τι εμφανίζεται σε αυτά τα παράθυρα διαλόγου, εξαπατώντας τους να εγκρίνουν την εκτέλεση κακόβουλου κώδικα.

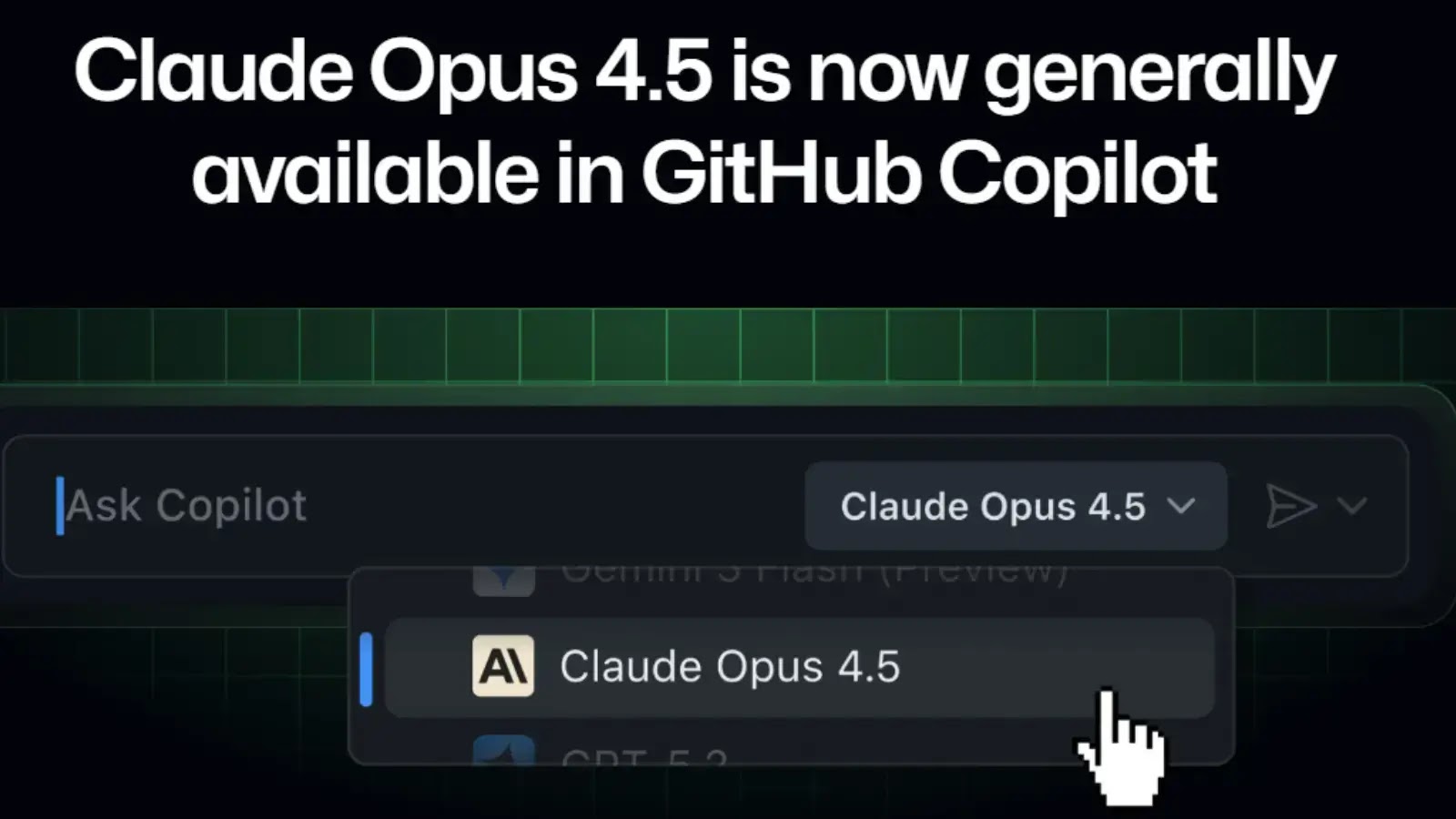

Ερευνητές του Checkmarx αναγνωρισθείς αυτός ο φορέας επίθεσης που επηρεάζει πολλές πλατφόρμες AI, συμπεριλαμβανομένων των Claude Code και Microsoft Copilot Chat.

.webp.png)

Η τεχνική εκμεταλλεύεται την εμπιστοσύνη που έχουν οι χρήστες σε αυτούς τους μηχανισμούς έγκρισης, χειραγωγώντας το περιεχόμενο διαλόγου μέσω έμμεσων επιθέσεων έγχυσης, επιτρέποντας στους απομακρυσμένους εισβολείς να εισάγουν κακόβουλες οδηγίες στο περιβάλλον του συστήματος.

.webp.jpeg)

Ο βασικός μηχανισμός λειτουργεί γεμίζοντας το κακόβουλο ωφέλιμο φορτίο με ένα ευνοϊκό κείμενο που ωθεί τις επικίνδυνες εντολές εκτός ορατού εύρους στα παράθυρα τερματικού.

Όταν οι χρήστες κάνουν κύλιση σε οδηγίες που φαίνονται αβλαβείς, εγκρίνουν εν αγνοία τους την αυθαίρετη εκτέλεση κώδικα στους υπολογιστές τους.

Σε μια επίδειξη, η επίθεση εκτέλεσε με επιτυχία το calculator.exe ως απόδειξη της ιδέας, αν και οι εισβολείς θα μπορούσαν να το χρησιμοποιήσουν για να αναπτύξουν περισσότερα επιζήμια ωφέλιμα φορτία.

Οι αναλυτές του Checkmarx σημείωσαν ότι η επίθεση γίνεται ιδιαίτερα επικίνδυνη όταν συνδυάζεται με τρωτά σημεία ένεσης Markdown.

Όταν οι εισβολείς χειραγωγούν την απόδοση της διεπαφής, μπορούν να δημιουργήσουν εντελώς πλαστά διαλόγους έγκρισης, καθιστώντας την επίθεση σχεδόν μη ανιχνεύσιμη από τους χρήστες που εξετάζουν τα μηνύματα.

Μηχανισμός μόλυνσης

Ο μηχανισμός μόλυνσης του Attack βασίζεται σε τρεις βασικές τεχνικές που λειτουργούν σε συντονισμό. Πρώτον, οι εισβολείς εισάγουν άμεσο περιεχόμενο στο περιβάλλον του πράκτορα AI μέσω εξωτερικών πηγών, όπως αποθετήρια κώδικα ή ιστοσελίδες.

Δεύτερον, ο πράκτορας AI δημιουργεί ένα φαινομενικά καλοήθη διάλογο HITL που βασίζεται στις δηλητηριασμένες οδηγίες.

Τρίτον, οι χρήστες εγκρίνουν το διάλογο χωρίς να συνειδητοποιούν το πραγματικό ωφέλιμο φορτίο που κρύβεται μέσα στο περιβάλλον κείμενο.

Η επίθεση πετυχαίνει επειδή οι χρήστες δεν μπορούν να δουν τι σκοπεύει πραγματικά να εκτελέσει ο πράκτορας κάτω από την παραπλανητική διεπαφή.

Τόσο η Anthropic όσο και η Microsoft αναγνώρισαν αυτά τα ευρήματα, αλλά τα ταξινόμησαν εκτός των τρεχόντων μοντέλων απειλών, αναφέροντας ότι απαιτούνται πολλαπλές μη προεπιλεγμένες ενέργειες για την εκμετάλλευση.

Ωστόσο, οι ερευνητές ασφαλείας τονίζουν ότι αυτό αντιπροσωπεύει μια θεμελιώδη πρόκληση στον σχεδιασμό πρακτόρων τεχνητής νοημοσύνης: όταν οι άνθρωποι εξαρτώνται από το περιεχόμενο διαλόγου που δεν μπορούν να επαληθεύσουν ανεξάρτητα, οι εισβολείς μπορούν να οπλίσουν αυτήν την εμπιστοσύνη.

Η ανακάλυψη υπογραμμίζει ότι καθώς τα συστήματα τεχνητής νοημοσύνης αποκτούν μεγαλύτερη αυτονομία, οι παραδοσιακές διασφαλίσεις ασφαλείας απαιτούν επανασχεδιασμό για την προστασία των χρηστών από την περίπλοκη κοινωνική μηχανική σε επίπεδο διεπαφής ανθρώπου-AI.