Ουσιαστικά, η Rubin ενσωματώνει τη νέα αρχιτεκτονική GPU της Nvidia, που έρχεται να αντικαταστήσει την προηγούμενη γενιά Blackwell/B300 στα data centers και τα workloads της τεχνητής νοημοσύνης. Ο σχεδιασμός της εστιάζει στη δραστική αύξηση της αποδοτικότητας κατά την εκπαίδευση και την εκτέλεση μοντέλων AI. Το όνομά της αποτελεί φόρο τιμής στη Vera Rubin, σημαντική Αμερικανίδα αστρονόμο που υπήρξε καθοριστική στη μελέτη των ταχυτήτων περιστροφής γαλαξιών και καμπυλών περιστροφής, αποκαλύπτοντας στοιχεία για τη σκοτεινή ύλη που άλλαξαν την αντίληψή μας για το Σύμπαν.

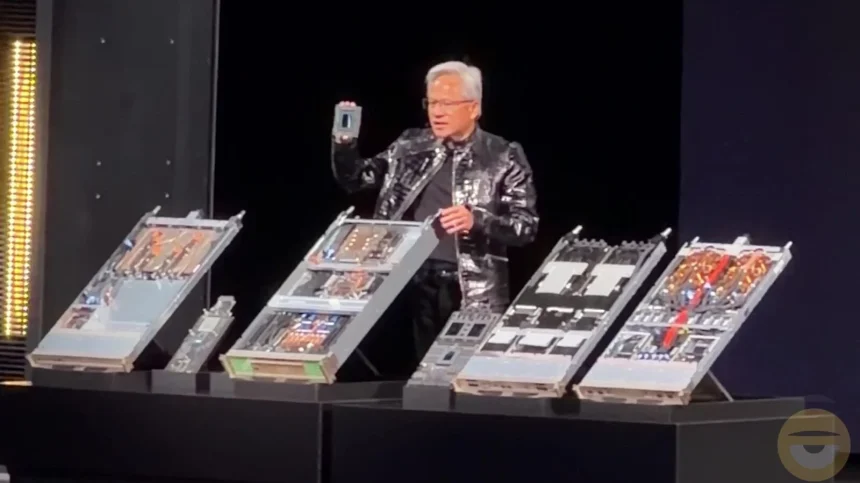

Σύμφωνα με τον CEO και ιδρυτή της Nvidia, Jensen Huang, η νέα πλατφόρμα στοχεύει στην υποστήριξη προηγμένων μοντέλων συλλογισμού και agentic AI, προσφέροντας λύσεις μέσω συνδυασμού πολλαπλών AI «expert» που βελτιστοποιούν τις ερωτήσεις για ένα πολυμεσικό και πολυδιάστατο μέλλον.

Ο Huang επεσήμανε ότι το Rubin παρουσιάζεται σε μια εποχή αυξανόμενης ζήτησης υπολογιστικής ισχύος για εκπαίδευση και inference. Το Vera Rubin ενσωματώνει, σε έναν μόνο επεξεργαστή, έναν Vera CPU και δύο Rubin GPUs, ενοποιώντας τη δύναμη τεχνητής νοημοσύνης με την ανάπτυξη νέας αρχιτεκτονικής. Αυτή η πλατφόρμα σηματοδοτεί, σύμφωνα με την εταιρεία, ένα ποιοτικό άλμα στην εξέλιξη της τεχνητής νοημοσύνης.

Εκτός από την Vera CPU και τις Rubin GPUs, η πλατφόρμα περιλαμβάνει και τέσσερα επιπλέον τσιπ που σχετίζονται με δίκτυα και αποθήκευση, όπως το Nvidia NVLink 6 Switch και το Nvidia ConnectX-9 SuperNIC. Αυτή η σύνθεση προορίζεται να λειτουργεί ως ενιαίο σύστημα για υποδομές ΤΝ μεγάλης κλίμακας.

Ο υπερυπολογιστής Nvidia Vera Rubin NVL72 μπορεί να ενσωματώσει όλα τα παραπάνω στοιχεία, συνδυάζοντας 72 GPUs σε ένα ενιαίο σύστημα. Οι πολλαπλές διασυνδέσεις NVL72 συνθέτουν το Nvidia DGX SuperPOD, μια συγκλονιστική υποδομή για την ΤΝ. Αυτά τα συστήματα απαιτούν επενδύσεις δισεκατομμυρίων από μεγάλες τεχνολογικές εταιρείες όπως οι Microsoft, Google, Amazon, καθώς και η Meta.

Επιπλέον, η Nvidia προβάλλει την τεχνολογία αποθήκευσης Inference Context Memory Storage, απαραίτητη για τη διαχείριση και αποθήκευση δεδομένων που παράγονται από μοντέλα με τρισεκατομμύρια παραμέτρους.

Η Ρubin υπόσχεται επίσης δραστική βελτίωση της αποδοτικότητας σε σύγκριση με την προηγούμενη γενιά Grace Blackwell. Σύμφωνα με τη Nvidia, η νέα πλατφόρμα προσφέρει τετραπλάσια μείωση στον αριθμό των GPU που απαιτούνται για την εκπαίδευση των μοντέλων MoE, επιτρέποντας στις επιχειρήσεις να αυξήσουν την αποδοτικότητα χρησιμοποιώντας τις «περισσευούμενες» μονάδες για εναλλακτικές εργασίες.

Τέλος, η Nvidia αναφέρει ότι η Rubin επιτυγχάνει δεκαπλάσια μείωση στο κόστος inference ανά token, που αναφέρεται σε στοιχεία όπως λέξεις και εικόνες, βελτιώνοντας το συνολικό κόστος κτήσης σε σύγκριση με τις προηγούμενες λύσεις της εταιρείας.