Το Threat Intelligence Group (GTIG) της Google έχει αναγνωρισθείς σημαντική κλιμάκωση της κακόβουλης χρήσης της τεχνητής νοημοσύνης. Οι αντίπαλοι δεν χρησιμοποιούν πλέον μόνο την τεχνητή νοημοσύνη για εργασίες παραγωγικότητας, όπως η σύνταξη μηνυμάτων ηλεκτρονικού ψαρέματος. Τώρα αναπτύσσουν νέο κακόβουλο λογισμικό που χρησιμοποιεί ενεργά την τεχνητή νοημοσύνη κατά τη διάρκεια μιας επίθεσης για να αλλάξει δυναμικά τη συμπεριφορά του.

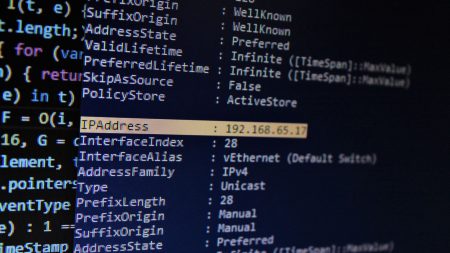

Αυτή η νέα φάση κατάχρησης τεχνητής νοημοσύνης περιλαμβάνει αυτό που η Google αποκαλεί AI «Just-in-Time». Για πρώτη φορά, το GTIG εντόπισε οικογένειες κακόβουλων προγραμμάτων που χρησιμοποιούν μοντέλα μεγάλων γλωσσών (LLM) στη μέση της εκτέλεσης. Αυτά τα εργαλεία μπορούν να δημιουργήσουν δυναμικά κακόβουλα σενάρια ή να συσκοτίσουν τον δικό τους κώδικα εν κινήσει για να αποφύγουν τον εντοπισμό, αντί να βασίζονται σε σκληρά κωδικοποιημένες λειτουργίες.

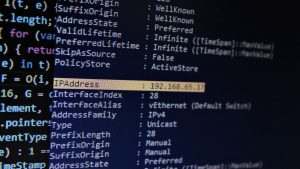

Η αναφορά περιγράφει λεπτομερώς αρκετές νέες οικογένειες κακόβουλου λογισμικού που χρησιμοποιούν αυτήν την τεχνική. Το “PROMTSTEAL”, το οποίο παρατηρήθηκε σε ενεργές λειτουργίες, είναι ένας εξορύκτης δεδομένων που ζητά ένα Hugging Face API σε ένα LLM για τη δημιουργία εντολών των Windows για τη συλλογή πληροφοριών συστήματος. Το “QUIETVAULT”, που εμφανίζεται επίσης στη φύση, είναι ένας κλέφτης διαπιστευτηρίων που χρησιμοποιεί εργαλεία AI CLI εγκατεστημένα στο μηχάνημα του θύματος για να αναζητήσει πρόσθετα μυστικά. Ένα άλλο κακόβουλο λογισμικό, το “FRUITSHELL”, περιέχει σκληρά κωδικοποιημένα μηνύματα που έχουν σχεδιαστεί ειδικά για να παρακάμπτουν την ανάλυση από συστήματα ασφαλείας που τροφοδοτούνται από LLM. Η Google εντόπισε επίσης πειραματικό κακόβουλο λογισμικό, συμπεριλαμβανομένου του “PROMPTFLUX”, ενός σταγονόμετρου που χρησιμοποιεί το Google Gemini API για να ξαναγράψει επανειλημμένα τον δικό του πηγαίο κώδικα για να παραμείνει κρυφό, και το “PROMPTLOCK”, ένα ransomware απόδειξης της ιδέας που δημιουργεί δυναμικά κακόβουλα σενάρια κατά την εκτέλεση.

Η έκθεση GTIG διαπίστωσε επίσης ότι οι παράγοντες απειλών προσαρμόζουν τις τεχνικές «κοινωνικής μηχανικής» για να παρακάμψουν τα προστατευτικά κιγκλιδώματα ασφαλείας της τεχνητής νοημοσύνης. Η Google παρατήρησε ηθοποιούς που παρίσταναν ως φοιτητές σε έναν διαγωνισμό «σύλληψη-η-σημαία» ή ως ερευνητές κυβερνοασφάλειας για να πείσουν τον Δίδυμο να παράσχει πληροφορίες, όπως βοήθεια για την ανάπτυξη εργαλείων, που διαφορετικά θα αποκλείονταν.

Οι κρατικοί φορείς, συμπεριλαμβανομένων εκείνων από τη Βόρεια Κορέα, το Ιράν και τη Λαϊκή Δημοκρατία της Κίνας (ΛΔΚ), συνεχίζουν να χρησιμοποιούν τεχνητή νοημοσύνη όπως το Gemini για να βελτιώσουν όλα τα στάδια των δραστηριοτήτων τους, από την αναγνώριση και τη δημιουργία δελεάσματος ηλεκτρονικού ψαρέματος έως την ανάπτυξη υποδομής διοίκησης και ελέγχου (C2). Επιπλέον, η Google σημειώνει ότι η υπόγεια αγορά για παράνομα εργαλεία τεχνητής νοημοσύνης έχει ωριμάσει το 2025, προσφέροντας πολυλειτουργικά εργαλεία που μειώνουν το εμπόδιο εισόδου για λιγότερο εξελιγμένους επιτιθέμενους.

Η Google δήλωσε ότι διακόπτει ενεργά αυτήν τη δραστηριότητα απενεργοποιώντας έργα και λογαριασμούς που σχετίζονται με αυτούς τους παράγοντες. Η εταιρεία τόνισε ότι βελτιώνει συνεχώς τα μοντέλα της, συμπεριλαμβανομένου του Gemini, για να τα κάνει λιγότερο επιρρεπή σε κακή χρήση και εφαρμόζει τις πληροφορίες για να ενισχύσει τους ταξινομητές ασφαλείας της.

VIA: DataConomy.com

.jpg)