Η συσκευή δημιουργίας εικόνων τεχνητής νοημοσύνης (AI) της Google προκαλεί ανησυχία λόγω της υπερρεαλιστικής φύσης του περιεχομένου που μπορεί να παράγει. Αναφέρεται ως Nano Banana ή Nano Banana Pro για την πληρωμένη έκδοση, προσφέρει μια νέα εποχή στον ρεαλισμό της εικόνας. Με αυτό, μπορείτε να δημιουργήσετε φωτογραφίες σας σε μια εκδήλωση στο κόκκινο χαλί ή σε διεθνείς διακοπές, ακόμα και όταν δεν έχετε πάει ποτέ σε αυτές τις τοποθεσίες. Αν και αυτό μπορεί να φαίνεται αρκετά ακίνδυνο, μπορείτε επίσης να δημιουργήσετε εικόνες άλλων ανθρώπων που βρίσκονται σε μέρη που δεν έχουν πάει ποτέ ή κάνουν πράγματα που δεν έχουν κάνει ποτέ — και αυτό μπορεί να είναι πρόβλημα.

Από τότε που η τεχνητή νοημοσύνη άρχισε να δημιουργεί εικόνες που ήταν κάπως ρεαλιστικές, τα πιθανά αποτελέσματα προκάλεσαν ανησυχία. Αυτή η ανησυχία τώρα ενισχύεται καθώς η τεχνολογία έχει βελτιωθεί, με το Nano Banana να είναι σχεδόν αδύνατο να διακριθεί από την πραγματικότητα, σύμφωνα με ορισμένους αναλυτές. Οι επικριτές του Nano Banana λένε ότι η Google δεν κάνει αρκετά για να αντιμετωπίσει δυνητικά προβληματικές περιπτώσεις χρήσης που συνδέονται με την τεχνολογία της, παρά το γεγονός ότι η Google έχει σαφείς πολιτικές που περιγράφουν την απαγορευμένη χρήση του μοντέλου της για την πλαστοπροσωπία ατόμων χωρίς συναίνεση.

Οι διασημότητες έχουν ήδη πέσει θύματα χειραγώγησης της ομοιότητάς τους μέσω AI. Δημιουργοί περιεχομένου, καλλιτέχνες, ακόμη και μεγάλες οντότητες όπως η Warner Bros. Discovery έχουν εκφράσει νομικές ανησυχίες σχετικά με τις δημιουργίες τους (ή την πνευματική ιδιοκτησία) που χρησιμοποιούνται χωρίς εξουσιοδότηση από την τεχνητή νοημοσύνη. Ψεύτικες αποδείξεις που δημιουργήθηκαν από την τεχνητή νοημοσύνη βρίσκουν τον δρόμο τους ακόμη και στην αίθουσα του δικαστηρίου. Αυτές οι περιπτώσεις, μεταξύ άλλων, εγείρουν ανησυχίες σχετικά με την προστασία της ιδιωτικής ζωής, τα δικαιώματα των καλλιτεχνών και τη διάδοση παραπληροφόρησης όσον αφορά την τεχνολογία AI.

Συγκεκριμένες περιπτώσεις ζητημάτων με τη δημιουργία εικόνων AI

Ο ρεαλισμός της δημιουργίας εικόνων Nano Banana AI της Google ενισχύει ένα πρόβλημα που ήδη υπάρχει. Υπήρξε μια διαμάχη για την εικόνα της τεχνητής νοημοσύνης με την Billie Eilish στο Met Gala του 2025. Αν και η εικόνα κέρδισε κάποια δημοτικότητα στο διαδίκτυο, προκαλώντας συζητήσεις για το ντύσιμό της, η ίδια η Eilish δήλωσε ότι είχε μια παράσταση στην Ευρώπη εκείνο το βράδυ και δεν παρευρέθηκε στο Met Gala. Η εικόνα ήταν ψεύτικη τεχνητή νοημοσύνη.

Στα μέσα του 2025, μια υπόθεση κατοικιών στην Καλιφόρνια πήγε στα δικαστήρια. Ένα αποδεικτικό στοιχείο που υποβλήθηκε ήταν ένα βίντεο ενός υποτιθέμενου μάρτυρα. Η δικαστής Victoria Kolakowski σκέφτηκε ότι κάτι δεν πήγαινε καλά με το βίντεο και συνειδητοποίησε ότι είχε δημιουργηθεί από AI. Ορισμένοι επαγγελματίες νομικοί πιστεύουν ότι το δικαστικό σύστημα είναι πιθανότατα απροετοίμαστο να αντιμετωπίσει αυτό το επίπεδο εξαπάτησης που εισάγουν εργαλεία τεχνητής νοημοσύνης όπως το Nano Banana, όσον αφορά τον όγκο, την προσβασιμότητα και την ποιότητα.

Έρευνα που έγινε από το Harvard Kennedy School διαπίστωσε ότι οι άνθρωποι είχαν μεγαλύτερη τάση να πιστεύουν ψευδείς τίτλους άρθρων εάν συνδυάζονταν με μια αξιόπιστη εικόνα που δημιουργήθηκε από AI. Μια τέτοια εικόνα που δημιουργήθηκε από τη μελέτη απεικόνιζε το Μουσείο του Λούβρου να καίγεται, συνοδευόμενη από τον τίτλο “Το Λούβρο εκκενώθηκε καθώς η ανεξέλεγκτη πυρκαγιά απειλεί τους θησαυρούς της τέχνης”. Η δημοσίευση τόνισε ότι η γενετική τεχνητή νοημοσύνη – ιδιαίτερα οπτικές ενδείξεις σε συνδυασμό με έγκυρο κείμενο – δημιουργεί πρόβλημα στη διάδοση της διαδικτυακής παραπληροφόρησης και απαιτεί τη θέσπιση καλύτερων διασφαλίσεων.

Η θέση της Google σχετικά με την κακή χρήση της τεχνολογίας AI

Από την πλευρά της, η Google έχει πολιτικές σχετικά με το τι επιτρέπεται και τι δεν επιτρέπεται σχετικά με τη δημιουργία εικόνων Nano Banana. Οι πολιτικές της περιγράφουν τη μη χρήση Nano Banana για παράνομες δραστηριότητες, τρομοκρατία, παραπληροφόρηση ή παραπλανητικό περιεχόμενο. Οι πολιτικές περιορίζουν επίσης τη χρήση εικόνων άλλων χωρίς συναίνεση, ένα πρόσφατο παράδειγμα υψηλού προφίλ είναι το Deepfake Scarlett Johansson AI που έγινε viral.

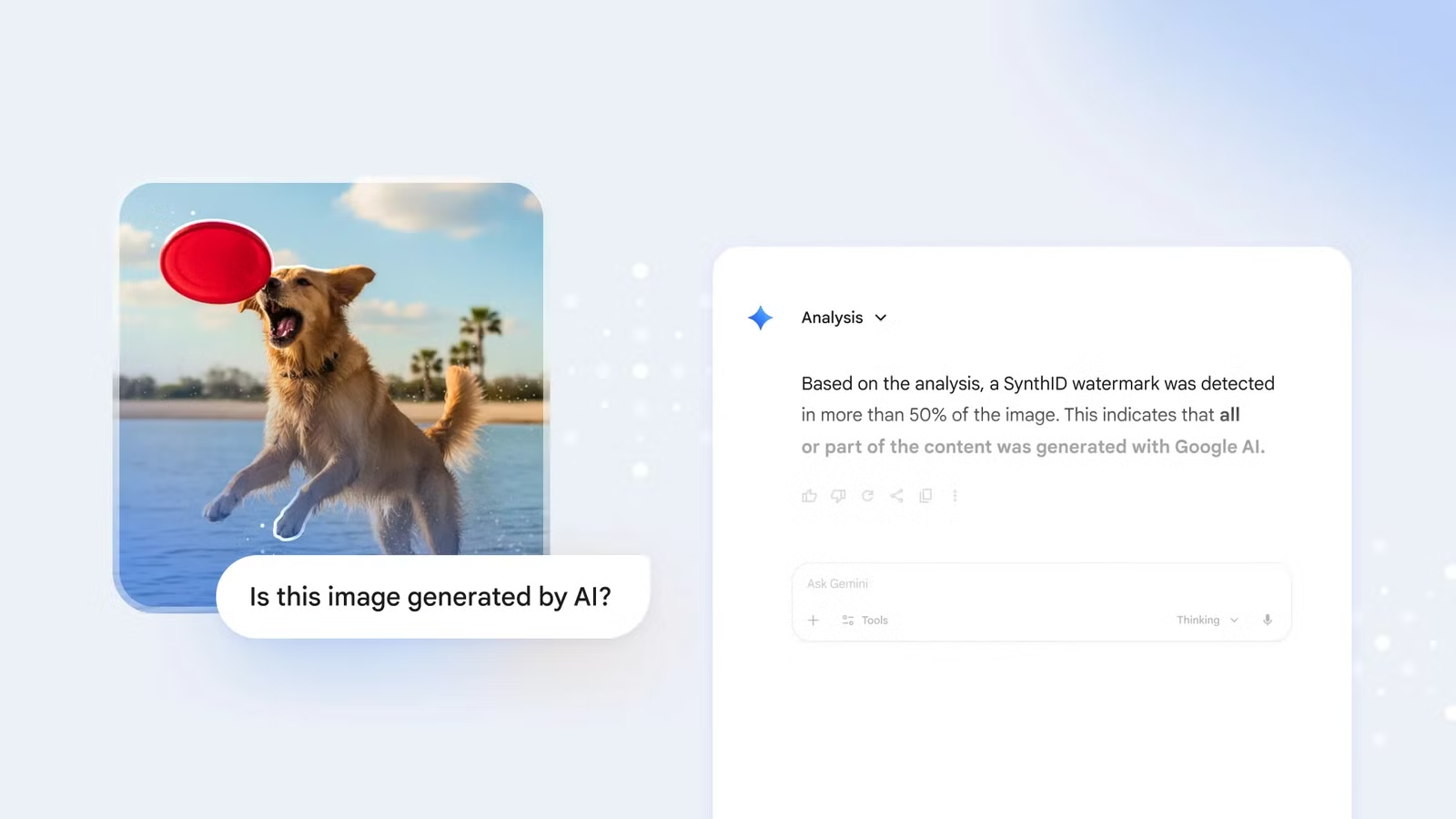

Το Nano Banana τοποθετεί επίσης ένα υδατογράφημα στην κάτω δεξιά γωνία των εικόνων που δημιουργούνται σε μια προσπάθεια να βελτιώσει τη διαφάνεια της προμήθειας. Ωστόσο, το εν λόγω υδατογράφημα κόβεται εύκολα και επομένως μπορεί να μην προσφέρει μεγάλη προστασία από κακή χρήση. Όσοι σκοπεύουν να χρησιμοποιήσουν το Nano Banana για την παραγωγή παραπληροφόρησης θα μπορούσαν να αφαιρέσουν ένα υδατογράφημα χωρίς προβλήματα.

Οι Όροι Παροχής Υπηρεσιών του Nano Banana είναι επίσης ανοιχτοί σε κριτική. Αναφέρει ότι η Google θα αναστείλει ή θα τερματίσει τους λογαριασμούς όσων δεν συμμορφώνονται με τις πολιτικές τεχνητής νοημοσύνης της Google. Δηλώνει, ωστόσο, ότι η Nano Banana δεν ευθύνεται για τυχόν προβλήματα που προκύπτουν από τη χρήση της πλατφόρμας της.

Via: bgr.com